学术 AI 使用引争议?AI 能当论文第一作者吗?

随着AI的快速崛起,人工智能已经渗入我们生活的方方面面,在学术写作上也有它的身影,不过任何事物都有其两面性,在为学术写作带来便利时,其背后的隐患也值得深思。

小佑在帮助一位同学申请海外博士时,就遇到了这么一个因AI带来的“小插曲”,该同学自述他在群面试时表现得十分不错,很多导师都想把票投给他,

本以为快要尘埃落定时,其中一位导师看到了他桌面上的ChatGPT又开始犹豫了,随后其他的导师也开始讨论AI是否可以应用于科研中,因此本可以快速得到导师认可的他,又因为桌面上的AI陷入了被动中.........。

像该同学这样因为AI带来的“小插曲”在现实生活中并不罕见,今天小佑想和大家讨论一下关于学术中AI的趋势以及它的争议之处。

AI使用现状与各地区态度

AI使用现状与各地区态度究竟怎么样?

这个问题先不回答,先来看一场由华东师范大学与斯坦福大学开展的关于AI的实验。

华东师范大学和斯坦福大学直接邀请AI坐上论文第一作者的宝座,开始了一场关于AI的实验。华东师范大学这个让AI当“主笔”的点子,可不是凭空想出来的。

其灵感正源自2025年7月斯坦福大学宣布将于年内举办的“科学AI智能体开放会议”(Agents4Science2025)。

(斯坦福大学官网)

这两所学校的规定可谓大胆到让人瞠目:AI不仅要当第一作者,还要在研究的各个环节——从提出假设到数据分析——唱主角。

华东师范大学智能教育实验室主任张治对此解释说,

这可不是要让AI取代人类,而是让研究者的身份来一次“华丽升级”,从亲自操刀变成战略指挥官。

想象一下这样的场景:人类负责出题和把控方向,AI则成了不知疲倦的科研助手,包揽那些基础的智力劳动。

更聪明的是,面对现在学生“偷偷用AI”写论文的现象,华东师范大学干脆来了个“阳光操作”,要求必须提交《AI生成内容说明表》,把一切摆在明面上。

这在一定程度上将AI的使用规划在合理合规的范围内。

此外,斯坦福大学的AI学术会议,简直像一面照妖镜,既照出了AI的巨大潜力,也暴露了它的奇葩局限。

会议组织者之一James Zou教授分享了他的神奇经历:他们团队让AI帮忙找能结合病毒的新抗体,结果AI独立完成了85%的工作,这效率简直让人类研究员汗颜。

可见AI适用于科研的确有其独特意义,比如基于大数据储备,处理问题效率高,但高效的背后也藏着局限性,这也正是其备受争议的部分:

华盛顿大学的团队想测试AI作为审稿人靠不靠谱,于是故意让AI扮演“不良科学家”,炮制了25篇问题论文——有的数据纯属编造,有的框架严谨却内容空洞。

你猜怎么着?这些“问题论文”的通过率竟然高达82%!AI审稿人虽然觉得“数据不对劲”,但还是大方地给了“强烈推荐”。

斯坦福大学的丽萨教授发现了更根本的问题:

有些AI写的论文,实验和数据都无可挑剔,但研究的问题却是“既不有趣也不重要”,完全是在正确的道路上做着无意义的事。

再来大致看一下国内外对于AI的态度:

国内的态度

根据麦可思2024年的数据,国内高校里几乎每一位老师和学生都在学习或工作中用过生成式AI,真正完全没用过的人只占10%左右。

可以说,生成式AI在高校里已经相当普及啦!如果把“每天多次使用”和“每周多次使用”都算作频繁使用的话,那么接近六成的高校师生都属于频繁使用者。

这其中,有18%的人每天要用上好几次,可以说是生成式AI的“重度用户”了。

也就是说AI使用在国内是普遍的,相比于全面禁止,国内更倾向于规范AI写作。

2024年底,复旦大学就打响了关于规范AI写作的“第一枪”,发布了全国首个专门管束本科毕业论文里用AI的规定——《复旦大学关于在本科毕业论文(设计)中使用AI工具的规定(试行)》。

这规定最引人注目的就是划出了“六个禁止”的红线,明确哪些地方绝对不能碰AI。

这一下可好,就像推倒了第一张多米诺骨牌。

深圳大学马上跟进了指导意见,中国传媒大学则直接给本科毕业论文下了加强管理的通知。

北京师范大学和华东师范大学联手整了份学生使用AIGC的指南,上海交通大学等一众名校也纷纷下场,出台了自己的规范。

说白了,核心就一句话:不是不让你用,是怕你乱用。

各校担心的焦点高度一致:你必须得自己掌控研究和写作的核心过程,不能当“甩手掌柜”,让AI替你思考和创作,那学术诚信的底线可就崩了

欧美的步伐

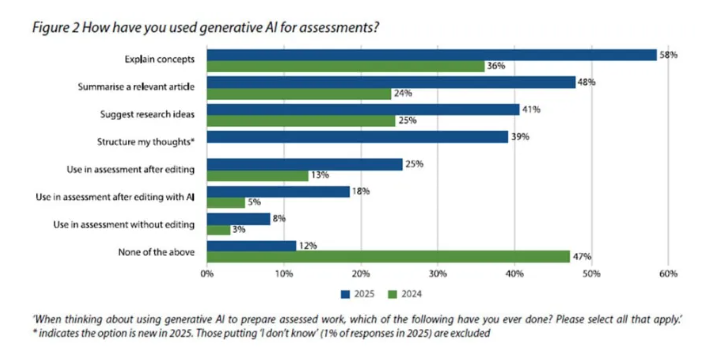

2025年,英国的HEPI和Kortext平台的《2025年学生生成式人工智能调查》显示:使用生成式人工智能工具如ChatGPT进行评估的学生比例从2024年的53%跃升至2025年的88%。

最常见的用途是生成式人工智能解释概念、总结文章和提出研究建议。未以此类方式使用生成式人工智能进行评估的比例,从去年的47%骤降至今年仅12%。

对于AI的普及,更多欧美高校却显得格外小心,活像担心孩子闯祸的家长。

欧盟在2025年7月公布了《通用人工智能行为准则》(The General-Purpose AI Code of Practice),给AI模型立下了三条规矩:要透明、要尊重版权、要保证安全。

( European Commission)

这份准则可不是说着玩的,它要求AI提供商必须亮出“底牌”——公开技术架构和训练数据来源。

更狠的是欧盟的《人工智能法案》,已经在2024年8月正式生效。要是企业敢违规,罚款最高能达到全球年营业额的7%,这数字足以让任何公司瑟瑟发抖。

美国这边,联邦层面在2020年就推出了《国家人工智能计划法》,重点支持AI研发。

而各州更是各自出招,加州和科罗拉多州在2024年分别制定了相关法规,重点关注AI应用的透明度和消费者权益保护。

学术圈的“两极态度”

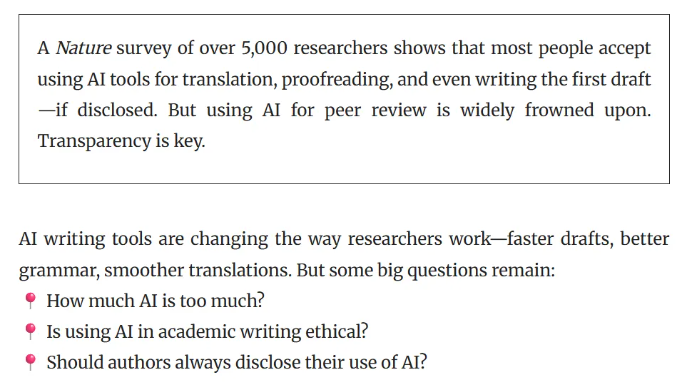

学术界对AI写作工具的态度,简直可以用“水火不容”来形容。《自然》杂志对全球约5000名学者的调查结果,充分展现了这种分裂。

关于用AI生成文本,约65% 的学者觉得在伦理上可以接受,但剩下的三分之一坚决反对。

问到具体能用在哪些部分,多数研究者能接受用AI写摘要,但更核心的内容就不行了。

一位加拿大地球科学研究者的话代表了反对派的心声:

“我永远不会原谅用生成式AI写或审论文,这就是可悲的作弊!”

但也有更开放的声音,一位西班牙人文学者说:

“我用AI在西班牙语和英语之间互译,然后会大量编辑,但我从不用AI从头生成内容。”

趋势:全面禁止or完全开放?

面对AI在学术领域的大潮,完全禁止或彻底放开显然都不靠谱,关键是要建立合理的规则。

华东师范大学张治教授的话很实在:现在硕博论文的AI渗透率已经超过70%,“视而不见不是负责任的大学该做的,那就像鸵鸟把头埋进沙子里。与其放任自流,不如正面应对”。

斯坦福和华东师大的实验代表了一种新思路——通过透明化和规范化,教会师生如何与AI协作,迎接科研方式的根本性变革。

芝加哥大学的教授提出了一个有趣的想法:AI应该更有“对抗性”,科研系统需要专门挑错的AI。

我们不需要千篇一律的AI。就像人类社会需要不同性格的人一样——不需要人人都当批评家,但必须有人承担这个角色。AI世界也应该如此多元。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。