游戏 AI 从状态机到效用系统,架构设计要点有哪些?

——当NPC开始“思考”,服务器该如何承载智能?

在现代游戏中,AI早已不只是“傻瓜式脚本”的代名词,从自适应的敌人战术到动态生成的剧情走向,AI正在让虚拟世界变得更“鲜活”。

然而,在架构层面,这背后远不止是算法问题,而是一个分布式计算与实时推理的系统工程。

本文将从系统架构设计师的角度,探讨如何构建一个可扩展、可并发、可进化的游戏AI系统架构,让“智能体”真正融入游戏生态。

NPC AI:从状态机到效用系统的演进

1、状态机:从“if-else地狱”到可视化逻辑

最早的NPC逻辑大多基于有限状态机(FSM, Finite State Machine),比如一个守卫NPC:

- 巡逻状态 → 发现玩家 → 进入战斗状态

- 战斗结束 → 搜索 → 恢复巡逻

简单、直观,但当AI行为复杂化后,FSM就会面临状态爆炸与逻辑交叉问题,维护成本急剧上升。

因此,现代游戏往往将FSM与行为树(Behavior Tree, BT)结合使用。

2、行为树:模块化决策的基础

行为树以树状结构描述AI的决策流程:

- 选择节点(Selector):尝试多种行为,选择第一个可执行的。

- 序列节点(Sequence):按顺序执行多个子行为。

- 条件节点:根据上下文状态决定行为分支。

行为树的优势是可复用、可调试、可扩展,策划可以在可视化编辑器中快速组合AI行为,而程序只需提供底层执行接口。

但行为树仍然偏向“确定逻辑”,难以表达模糊的优先级、欲望或资源竞争。

3、效用系统(Utility AI):让NPC更“像人”

效用系统的核心思想是:用函数评估每个行为的“期望收益”,然后动态选择效用值最高的行为。例如:

- 攻击行为的效用 = 敌人威胁度 × 攻击成功率

- 逃跑行为的效用 = 自身血量低 × 敌人数量多

这种方式让AI具备了上下文自适应能力,能在复杂场景中做出“看似聪明”的决策。

大型开放世界游戏(如《荒野大镖客2》《赛博朋克2077》)的AI系统普遍采用这种机制。

机器学习:AI从规则走向“推理”

当AI的复杂度进一步提高,基于规则的系统开始力不从心,此时,机器学习(ML)模型被引入游戏系统中,但如何让它与实时性要求极高的游戏逻辑兼容,是架构设计的关键。

1、模型推理:从离线到实时

AI模型在游戏中主要分为两类使用场景:

- 离线推理(Offline Inference):用于生成关卡、调整NPC参数、学习玩家行为模式 ⇒ 运行在后台或工具链中,对实时性能要求低。

- 实时推理(Online Inference):用于战斗策略、语音响应、动态对话等 ⇒ 必须在毫秒级内响应。

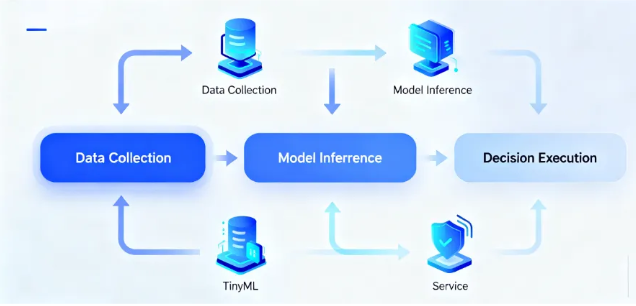

因此,架构上需要在推理端引入轻量化模型(TinyML)或模型蒸馏(Distillation),甚至使用专门的推理服务(Inference Service)来分担主逻辑压力。

2、模型部署:与游戏服解耦

在生产环境中,AI模型部署通常遵循“微服务化”思路:

- 每个AI模型独立部署为一个服务节点;

- 游戏服务器通过RPC或消息队列与之交互;

- 服务节点可根据负载动态伸缩。

例如:

玩家触发战斗 → 战斗服发起AI请求 → AI推理服务计算 → 返回NPC行动决策这种解耦设计允许AI模块独立迭代,不影响游戏主流程的稳定性。

3、A/B测试:让AI持续学习

游戏AI也需要持续优化,通过A/B测试,可以验证不同AI策略的玩家反馈差异:

- A组使用传统FSM逻辑;

- B组使用强化学习模型;

- 对比留存率、挑战成功率、平均对局时长。

在服务端架构中,可以利用实验配置中心(Experiment Config Center)动态分配AI策略版本,实现灰度发布与可回滚。

分布式计算:AI任务的调度与执行

AI的计算负载往往不均匀,尤其是MMO游戏中几千个NPC同时计算路径或策略时,这就需要一个分布式计算框架,让AI计算在多节点间合理分配。

1、任务切分:从单服到分布式

常见的AI任务可分为三类:

- 实时任务:如NPC追踪、战斗判断,要求低延迟;

- 批处理任务:如路径预计算、聚类分析;

- 背景任务:如AI日志分析、模型再训练。

系统通常将这些任务分发到不同计算节点中,通过任务队列(如Kafka、RabbitMQ)协调。

2、AI计算节点的角色划分

在分布式架构中,AI节点通常包括:

- Master节点:任务调度与负载监控;

- Worker节点:执行推理任务;

- Cache节点:缓存常用模型参数或特征数据;

- Result Aggregator:汇总结果并返回给游戏逻辑服。

这种架构保证了高并发与高可用,也便于模型的热更新。

3、边缘计算:让AI更靠近玩家

在全球同服或跨地域部署场景中,可以将部分AI推理下沉到边缘节点(Edge Node),减少延迟。例如:

- 亚太玩家请求由东京AI节点处理;

- 欧洲玩家由法兰克福AI节点响应。

这类架构往往结合CDN网络,实现“智能体的地理就近推理”。

性能优化:AI负载的动态调整

AI再智能,也要受限于算力与延迟,一个优秀的架构设计师,必须在智能与性能之间找到平衡点。

1、动态降级机制

当系统检测到AI计算负载过高时,可以自动降级:

- 优先执行核心AI(战斗AI),延迟执行次要AI(环境AI);

- 降低推理频率或切换到简化逻辑版本(FSM fallback);

- 限制AI感知范围或更新周期。

这种“自适应AI策略”保证系统在高峰期仍能稳定运行。

2、缓存与复用

- 对重复性高的AI判断(如寻路结果、战术评估)进行缓存;

- 利用相似场景复用AI决策结果(如同一类型敌人的策略模板);

- 对AI状态使用时间片调度,错开计算峰值。

3、异步与批量执行

将AI计算批量化,可大幅提升吞吐量;例如将多个NPC决策打包成批次请求给推理服务,返回后再拆分分发;同时,利用异步机制(Future/Promise)可避免阻塞游戏主线程。

结语:让AI成为“游戏的一部分架构”

过去AI是“附属模块”;如今,AI已成为游戏系统的一等公民(First-Class Citizen)。

从行为树到分布式推理,从规则逻辑到机器学习,AI系统架构正逐步演化为支撑游戏世界智能化的“神经网络”。

对于架构设计师而言,关键不在于选择哪种AI算法,而在于如何让AI在可扩展的系统中稳定运行、持续学习、自然进化。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。