RAG、微调、提示工程:三种让AI变聪明的方法,该怎么选?

AI能认识你吗?这个问题比你想的更有趣

还记得多年前,我们喜欢在Google上搜索自己的名字,看看互联网"知道"多少关于我们的信息吗?现在,这个游戏有了升级版——去问问ChatGPT或其他大语言模型:“你知道我是谁吗?”

当我问"XX是谁?"时,不同的AI模型给出的答案千差万别。有的说他是IBM的技术专家,有的说他是XX鞋业的创始人,还有的压根不知道这个人。为什么?因为不同模型的训练数据不同,知识截止日期不同,它们对世界的"认知"自然也不一样。

但这引出了一个更重要的问题:如何让AI给出更准确、更有用的答案?

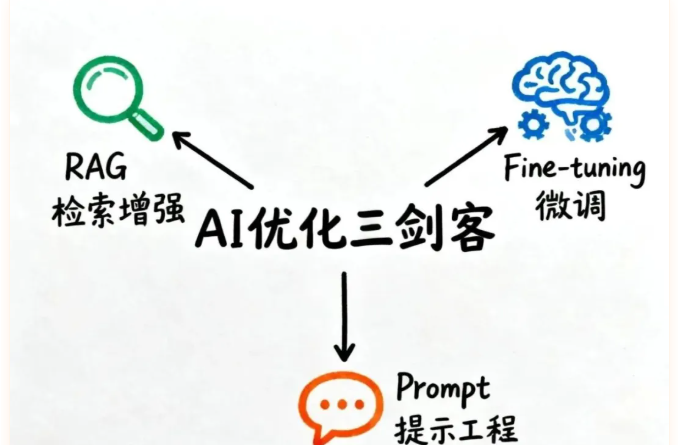

答案是:有三种主流方法——RAG(检索增强生成)、Fine-tuning(微调)和Prompt Engineering(提示工程)。今天,我们就来拆解这三种方法,看看它们各自的魔力、适用场景,以及该如何选择。

方法一:RAG——给AI装上"实时搜索引擎"

想象一下,你在参加一场重要的商业会议,突然有人问你:"去年第四季度公司的营收增长是多少?"如果你记忆力超群,能直接回答,那当然最好。但如果记不清,你会怎么做?大概率是掏出手机,翻翻财务报表,然后给出答案。

RAG就是给AI装上这样一个"实时查资料"的能力。

RAG的三步魔法

RAG的全称是Retrieval Augmented Generation(检索增强生成),它的工作流程可以分为三步:

第一步:检索(Retrieval)——当用户提问时,系统会去一个巨大的"资料库"里搜索相关信息。这个资料库可能是你公司的内部文档、产品手册、历史邮件,甚至是最新的新闻报道。

第二步:增强(Augmentation)——系统把找到的信息"塞"进原始问题里,形成一个更丰富的上下文。就像你在会议上说"根据财务部门提供的数据显示……“一样,给AI提供了"证据”。

第三步:生成(Generation)——AI基于这些"实锤"信息,生成最终答案。

向量嵌入:不只是关键词匹配

这里有个关键技术点:向量嵌入(Vector Embeddings)。

传统的搜索引擎只会匹配关键词——你搜"营收增长",它只能找包含这两个词的文档。但RAG更聪明,它会把你的问题和所有文档都转化成一串数字(向量),然后计算它们在"语义空间"里的距离。

这意味着什么?即使文档里写的是"第四季度业绩表现"或"quarterly sales",RAG也能判断出它们和你的问题"营收增长"在语义上是相关的,因为它们在向量空间里"靠得很近"。

RAG的优势:实时+专业

RAG最大的优势有两个:

- 信息永远是最新的。你不需要重新训练模型,只要更新资料库里的文档,AI就能立刻"学会"新知识。今天上午的董事会决议,下午就能被AI引用。

- 能处理高度专业的领域知识。你公司的内部规章制度、行业黑话、产品技术细节,这些"小众"知识,RAG都能轻松整合进AI的回答。

RAG的劣势:速度与成本

但天下没有免费的午餐,RAG也有代价:

- 响应速度变慢。每次回答问题前都要先"翻资料",自然比直接回答要慢。

- 基础设施成本高。你需要维护一个向量数据库,存储所有文档的嵌入向量,还要持续更新索引。这对算力和存储都有要求。

方法二:Fine-tuning——给AI上"专业培训课"

如果说RAG是"临时抱佛脚查资料",那么Fine-tuning就是"提前上培训课",把知识直接"刻"进AI的"大脑"里。

Fine-tuning的工作原理:改造AI的"神经元"

Fine-tuning的逻辑是:拿一个已经很聪明的通用模型(比如GPT-4),然后用你的专业数据对它进行"再教育"。

具体来说,模型内部有数十亿个参数(可以理解为"神经元连接的强度"),这些参数在预训练阶段就已经优化过了。Fine-tuning要做的,就是在这些参数上进行微调——不是推倒重来,而是小幅度修正。

这个过程通常使用监督学习:你提供成千上万个"问题-标准答案"对,让模型反复练习,直到它学会在这个领域"说人话"。比如,你想训练一个客服AI,就给它看几千个真实客户咨询记录和客服的标准回复,让它学会识别常见问题模式,掌握专业话术。

Fine-tuning的优势:深度专业化+速度快

Fine-tuning的最大亮点是:

- 深度领域专业化。模型不只是"知道"知识,而是真正"理解"了这个领域的思维方式、术语体系和回答逻辑。它变成了一个"领域专家",而不是"资料搬运工"。

- 推理速度快。因为知识已经"烧"进模型权重里了,回答问题时不需要外部检索,响应速度比RAG快得多。

- 不需要额外基础设施。你不需要维护向量数据库,部署起来更简单。

Fine-tuning的劣势:成本高+维护难

但Fine-tuning也有明显的痛点:

- 训练复杂度高。你需要准备数千甚至上万条高质量训练样本,这本身就是个大工程。

- 计算成本惊人。训练一个Fine-tuned模型可能需要好几块GPU连续跑几天,电费和机器成本都不便宜。

- 更新麻烦。RAG里你只要添加新文档就行,但Fine-tuned模型要更新知识,就得重新训练一轮。

- 灾难性遗忘风险。这是个专业术语,说的是模型在学习新知识时,可能会"忘掉"一些通用能力。就像你专心学医学,可能把高中数学都还给老师了。

方法三:Prompt Engineering——学会"问对问题"

如果说RAG和Fine-tuning都是"改造AI",那么Prompt Engineering就是"改造你自己"——学会用AI听得懂的方式提问。

从"你知道Keen吗"到精准提问

最简单的例子:

- ❌ 差劲的提问:“这段代码安全吗?”

- ✅ 优化后的提问:“作为一名安全专家,请审查以下Python代码,重点关注SQL注入、XSS攻击和敏感数据泄露风险,并按严重程度排序列出所有潜在漏洞,每个漏洞给出具体的修复建议。”

看出区别了吗?第二个问题给了AI明确的"角色"(安全专家)、“任务”(审查代码)、“关注点”(三类风险)和"输出格式"(按严重程度排序+修复建议)。

Prompt Engineering的原理:激活潜能

Prompt Engineering的魔力在于,它能激活模型在训练时学到的相关模式。

当你说"请一步步思考这个问题"时,模型会调用它在训练数据中见过的那些"逐步推理"案例的模式,从而给出更严谨的答案。当你说"请用表格形式总结",它会调用表格化信息的模式。

你没有改变模型,也没有给它新数据,只是通过更好的"问法",让它把已有能力发挥到极致。

Prompt Engineering的优势:零成本+即时见效

这个方法的优势显而易见:

- 完全零成本。你不需要训练模型,不需要搭建检索系统,甚至不需要技术团队——任何人都能学。

- 立竿见影。改一下提问方式,马上就能看到效果提升。

- 灵活性极高。针对不同任务,你可以快速调整提示词,而不需要重新训练或重建索引。

Prompt Engineering的劣势:艺术多于科学

但它也有局限:

- 高度依赖技巧和经验。什么样的提示词有效,往往需要大量试错。这更像是一门"艺术"而非"科学"。

- 无法突破知识边界。如果模型压根不知道某个信息(比如今天的新闻),再怎么优化提示词也没用。

- 输出不够稳定。同样的提示词,在不同模型或不同版本上,效果可能差异很大。

最佳实践:三者组合使用

这里有个重要认知:RAG、Fine-tuning和Prompt Engineering并不是互斥的选择题,而是可以组合使用的工具箱。

举个例子:一个法律AI助手可以这样设计:

- Fine-tuning:让模型深度学习法律文书的写作规范、法律术语和推理逻辑,使其具备"法律人思维"。

- RAG:实时检索最新的判例、法律修订和法院公告,确保引用的案例都是最新的。

- Prompt Engineering:用精心设计的提示词,确保输出的法律文书格式规范、逻辑严密、引用准确。

这样一来,你就同时拥有了深度专业能力、实时信息更新和精准输出控制。

如何选择?一张表格说清楚

| 维度 | Prompt Engineering | RAG | Fine-tuning |

|---|---|---|---|

| 成本 | 几乎为零 | 中等(需维护向量库) | 高(GPU+训练时间) |

| 速度 | 最快 | 较慢(需检索) | 快 |

| 知识更新 | 无法更新 | 实时更新 | 需重新训练 |

| 专业深度 | 浅(仅激活已有能力) | 中等 | 深(改造模型思维) |

| 适用场景 | 通用任务、快速迭代 | 需要实时信息、知识库问答 | 深度领域专家系统 |

| 技术门槛 | 低(任何人可学) | 中等(需工程团队) | 高(需ML专家) |

我的建议:

- 如果你刚开始探索AI应用,从Prompt Engineering入手,这是性价比最高的方式。

- 如果你需要AI访问实时信息或企业内部知识库,优先考虑RAG。

- 如果你在构建一个需要深度领域专业能力的系统,且有预算和技术团队,再考虑Fine-tuning。

写在最后:选对方法,让AI真正为你工作

从"在Google上搜自己"到"问AI关于自己",技术的进步让我们与机器的交互方式发生了根本变化。

但更重要的是,我们现在有了多种工具来"调教"AI,让它更好地服务我们。无论是给它装上实时搜索能力(RAG),还是让它接受专业培训(Fine-tuning),亦或是学会更聪明地提问(Prompt Engineering),每种方法都有其独特价值。

关键在于:理解你的需求,选对工具,甚至组合使用。

毕竟,AI不是魔法,而是一套可以被优化、被定制、被驾驭的工具。掌握了这三种方法,你就拿到了驾驭AI的方向盘。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。