NVIDIA Vera Rubin 架构:VR NVL72机柜

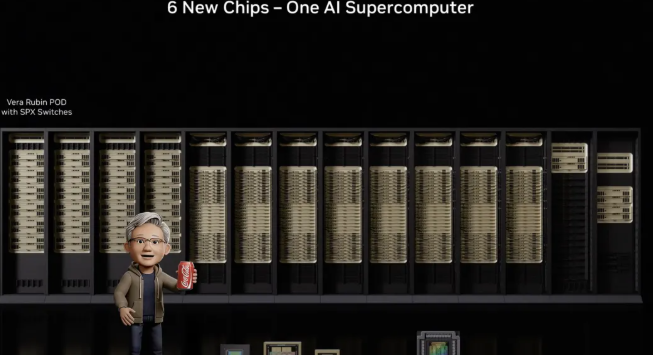

在2026年CES展会上,NVIDIA发布了以Vera Rubin NVL72机柜级系统为核心的鲁宾平台。这是NVIDIA第三代机柜级架构,将六款协同设计的芯片整合为统一系统。该平台将于2026年下半年通过合作伙伴面市,目前所有六款芯片已完成流片,正通过实际工作负载进行验证。

主要内容:

- Vera Rubin NVL72:六芯合一,系统融合

- Vera CPU:专为AI工厂设计的ARM芯片

- 代际对比:Blackwell Ultra 与 Vera Rubin NVL72

- Rubin GPU:Transformer引擎、NVFP4与HBM4

- NVLink 6:机柜级全互联架构

- ConnectX-9超级网卡:重新定义横向扩展网络架构

- BlueField-4 DPU与ASTRA安全架构

- 全机柜可信计算体系

- MoE模型的成本与能效优化

- 专为超大规模设计的无缆线机柜架构

- 推理上下文内存存储平台

- 写在最后

Vera Rubin NVL72:六芯合一,系统融合

Vera Rubin NVL72采用了英伟达所称的“极限协同设计”理念,通过将六款独立芯片统一开发,实现整体系统级协同运作。

Vera CPU:专为AI工厂设计的ARM芯片

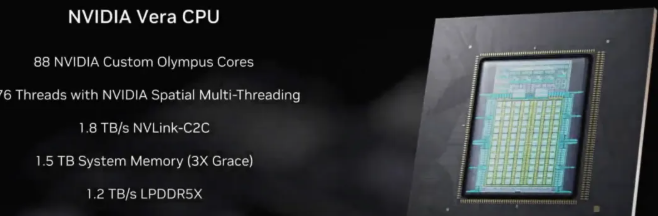

首先展示的是NVIDIA Vera CPU,标志着NVIDIA继续为AI工作负载定制ARM芯片的投入。Vera基于88个定制Olympus ARM核心构建,完全兼容Armv9.2架构,专门针对现代AI工厂的数据传输和智能体处理需求设计。其搭载的NVLink-C2C互联技术可为Rubin GPU提供1.8 TB/s带宽,较前代C2C带宽提升两倍,运行速度比PCIe Gen 6快七倍。与上一代Grace CPU相比,Vera在数据处理、压缩和代码编译方面的性能均实现翻倍提升。

代际对比:Blackwell Ultra 与 Vera Rubin NVL72

| Specification | GB300 NVL72 (Blackwell Ultra) | VR NVL72 (Vera Rubin) |

|---|---|---|

| GPU数量 | 72 Blackwell Ultra GPUs | 72 Rubin GPUs |

| CPU数量 | 36 Grace CPUs | 36 Vera CPUs |

| CPU核心 | 72 ARM核 / CPU | 88 Olympus ARM核 / CPU |

| FP4 推理性能 | 1.44 ExaFLOPS | 3.6 ExaFLOPS |

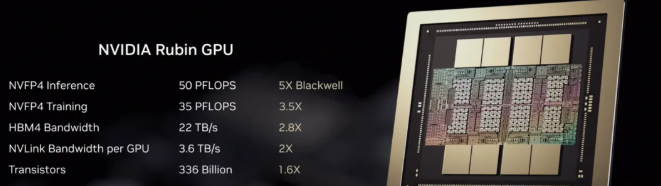

| NVFP4 / GPU (推理) | 20 PFLOPS | 50 PFLOPS |

| NVFP4 / GPU (训练) | 10 PFLOPS | 35 PFLOPS |

| GPU 显存类型 | HBM3e | HBM4 |

| GPU 显存带宽 | ~8 TB/s | ~22 TB/s |

| NVLink 代际 | NVLink 5 | NVLink 6 |

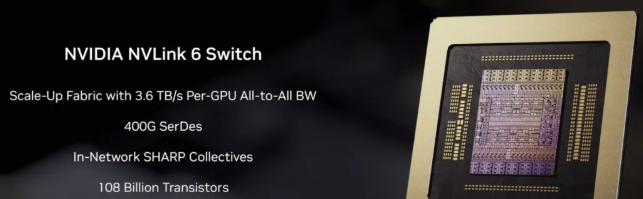

| NVLink 带宽 / GPU | 1.8 TB/s | 3.6 TB/s |

| 机柜级NVLink带宽 | 130 TB/s | 260 TB/s |

| 横向扩展网卡 | ConnectX-8 (800 Gb/s) | ConnectX-9 (1.6 TB/s) |

| CPU-GPU互联架构 | NVLink-C2C (900 GB/s) | NVLink-C2C (1.8 TB/s) |

Rubin GPU:Transformer引擎、NVFP4与HBM4

接下来登场的是发布会焦点——NVIDIA Rubin GPU。该芯片搭载第三代Transformer引擎,具备硬件加速自适应压缩功能,可动态调整Transformer各层计算精度:在可降低精度处实现更高吞吐量,在关键计算层保持准确性。该NVFP4实现提供了50 Petaflops推理算力(相当于Blackwell的5倍)和35 Petaflops训练算力(相当于Blackwell的3.5倍)。作为首款集成HBM4存储器的GPU,其带宽高达22 TB/s,这一重大突破有效缓解了大型混合专家模型面临的内存带宽瓶颈。

NVLink 6:机柜级全互联架构

NVIDIA NVLink 6交换机将单GPU带宽提升至3.6 TB/s,整机柜纵向扩展网络总带宽达260 TB/s——超过全球互联网截面总带宽的两倍。该纵向扩展架构支持所有GPU间实时全互联通信(满足MoE专家并行计算需求),实现集群内所有专家模型结果同步交换。内置网络计算单元可加速集合运算并缓解拥堵,将原本消耗GPU算力的任务进行卸载处理。

ConnectX-9超级网卡:重新定义横向扩展网络架构

NVIDIA ConnectX-9超级网卡专门用于横向扩展网络互联,为每颗GPU提供1.6 TB/s的RDMA带宽,实现跨机柜通信。该网卡与Vera CPU协同设计以最大化数据路径效率,并首次引入全软件定义可编程加速数据通道,使AI实验室能够针对特定模型架构定制优化数据传输算法。

BlueField-4 DPU与ASTRA安全架构

BlueField-4作为NVIDIA 第四代数据处理单元,代表了对AI工作负载存储与网络架构的根本性重构。新一代DPU搭载64核NVIDIA 级CPU(BlueField-3为16核ARM Cortex-A78),计算性能提升6倍。其采用协同封装的ConnectX-9超级网卡(BlueField-3为ConnectX-7),网络带宽翻倍至800 Gb/s。GPU数据存储访问速度较前代提升2倍。除规格升级外,BlueField-4的核心价值在于实现了全新层级的AI原生存储基础设施——NVIDIA 将其定位为实现规模化智能体AI的关键基石。

BlueField-4通过卸载网络、存储与安全处理任务,确保Rubin GPU和Vera CPU能专注执行模型计算。该单元已完全集成至NVIDIA企业级AI工厂验证设计方案,并获得红帽、Palo Alto Networks、Fortinet等生态伙伴的支持。

BlueField-4同步推出ASTRA(先进可信资源架构)。该体系级可信架构提供统一控制点,可在不影响性能的前提下实现大规模AI环境的安全配置、隔离与运维。

全机柜可信计算体系

Vera Rubin NVL72成为首个实现全系统NVIDIA可信计算的机柜级平台。第三代可信计算技术覆盖CPU、GPU及整个NVLink域的数据安全防护,对所有总线传输进行全程加密。这有效解决了企业及AI实验室在共享基础设施上运行专有模型时的核心关切:即便部署于第三方系统,也能确保模型、训练数据和推理工作负载的全程安全防护。

NVIDIA Spectrum-6以太网交换机驱动其横向扩展网络架构。该交换机基于200G SerDes技术并采用共封装光学模块(CPO),实现102 TB/s交换容量,为跨VR NVL72机柜的东西向流量提供支撑。转向CPO技术具有重大意义:通过将光学器件直接集成至交换芯片,英伟达宣称其可靠性提升10倍,持续运行时间延长5倍,能效较传统可插拔光模块优化5倍。

MoE模型的成本与能效优化

NVIDIA 宣称,在相同延迟条件下,VR NVL72运行大型MoE模型推理的每token成本降至Blackwell平台的七分之一。训练同等规模大型MoE模型时,所需GPU数量仅需Blackwell平台的四分之一即可在相同时间内完成。该平台每瓦推理算力实现8倍提升。

这些改进正好满足MoE模型的特殊需求——该类模型对每个输入token仅激活部分专家层。以Kimi K2 Thinking等模型为例:其包含384个专家层,但每次仅激活8个,这需要海量全互联GPU通信支持。VR NVL72提供的260 TB/s纵向扩展网络带宽正是为此类通信模式而设计。

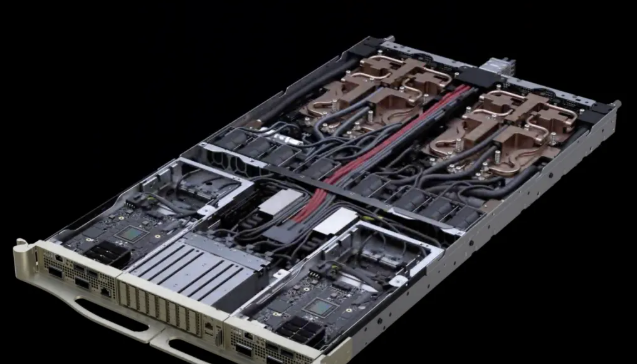

专为超大规模设计的无缆线机柜架构

VR NVL72采用模块化无缆线、无风扇、无软管托盘设计,仅通过PCB板与连接器实现内部互联,彻底摒弃内部线缆。计算托盘插入机柜时通过盲插连接器自动对接,无需人工布线。全系统仅保留两根外部液态冷却进出口管路与冷却模块连接。

早期系统(如GB300 NVL72)组装单个计算托盘约需100分钟。每个线缆连接点都可能成为故障源,在数十万GPU规模下这一问题尤为突出。线缆排布不仅制约冷却风道、挤占空间,风扇更带来机械复杂性及噪声问题。

全新设计将组装维护时间缩短至原先的1/18。该平台还搭载第二代RAS(可靠性、可用性、可服务性)引擎,覆盖GPU、CPU及NVLink全链路,提供实时健康检测、容错机制与主动维护功能。NVLink交换托盘现支持零停机维护,允许在移除或部分装载交换托盘时保持机柜持续运行。在数十万GPU的超大规模集群中,这些可维护性改进直接转化为集群运行时长与有效吞吐量的提升。

该架构为未来更高密度配置奠定基础。这也为实现先前在AI基础设施峰会上预告的Vera Rubin CPX机柜设计方案提供了关键支撑——该设计在现有高密度架构基础上,于同一计算模块中进一步集成上下文处理GPU单元。

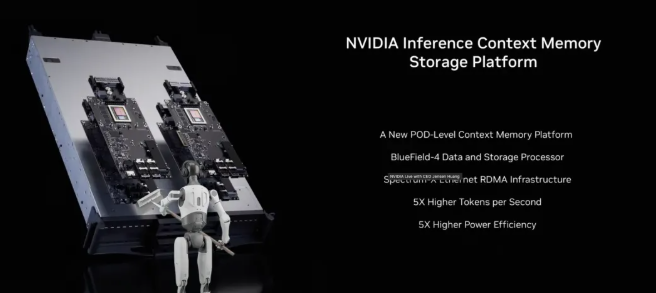

推理上下文内存存储平台

NVIDIA 在2026年国际消费电子展上发布了推理上下文内存存储平台,这是一类专为KV缓存构建的AI原生存储基础设施。该平台由BlueField-4和Spectrum-X以太网络驱动,相比传统用于推理上下文的网络存储,可实现每秒高达5倍的token吞吐量提升、单位总拥有成本下5倍的性能提升、5倍的能效优化以及20倍的首token响应时间提升。BlueField-4的硬件加速KV缓存布局技术消除了元数据开销并减少数据迁移,而Spectrum-X以太网则为基于RDMA的访问提供了高带宽、低延迟的网络架构。

该平台针对大语言模型推理中日益突出的KV缓存管理瓶颈而设计。Transformer模型采用注意力机制,每个生成token都需要关注之前所有token。若不进行缓存,则需为每个token重新计算键值向量,导致复杂度达到O(n²)。KV缓存技术将这些预计算矩阵存储在内存中复用,将复杂度降至O(n)。但问题在于KV缓存容量会随序列长度和批次大小呈线性增长——单次长上下文对话就可能消耗数GB内存。在多租户环境中,面对数千个并发请求且上下文窗口扩展至百万级token时,GPU高带宽内存将迅速耗尽。运营者将被迫选择降低批次规模、缩短上下文窗口,或增购GPU硬件。

传统网络存储并非为KV缓存访问模式设计——该模式需要对分散于海量并发会话、可能达TB级的瞬时数据进行低延迟随机访问。推理上下文内存存储平台为此类工作负载提供了专用存储层级,定位介于GPU高带宽内存与传统存储之间。这使得AI工厂能够将上下文容量扩展与GPU计算资源解耦独立。NVIDIA曾利用Dynamo结合Pliops的KV缓存加速器实现卸载方案,此次NVIDIA通过推理上下文内存存储平台将其规模化,并整合至其开源Dynamo项目中。该软件框架将解耦的预填充/解码阶段、智能路由及新型平台的分层存储卸载功能深度融合。

包括VAST Data、NetApp、DDN、戴尔科技、HPE、日立Vantara、IBM、Nutanix、Pure Storage及WEKA在内的存储合作伙伴,正基于BlueField-4构建存储平台。这些产品将于2026年下半年正式上市。

写在最后

NVIDIA的这种拉满极致的产品研发与迭代速度,对AI市场进行了无限放大,对刚刚采购Blackwell架构的算力客户,是不是一种背刺?同时,Buy More,Save More的口号,是有一个潜在前提,叫Buy More,而且这个More,应该是几何级数的More,起步价越来越高了!高到离谱!

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。