GPU服务器SSD可靠性指标有哪些?怎么测试?

GPU服务器的SSD可靠性直接关系到AI训练、科学计算等高价值任务的连续性和数据安全。

主要内容:

- 1. SSD可靠性关键指标

- 2. 测试方法与工具

- 3. 针对GPU服务器的特别建议

- 4. 测试流程总结

- GPU服务器存储性能指标有哪些?如何测?

- 白话GPU-11 GPU服务器SSD的NVMe、U.2、M.2、AIC、EDSFF是啥?热插拔咋搞?

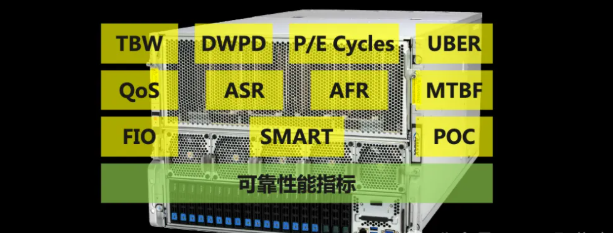

1. SSD可靠性关键指标

SSD可靠性关键指标可分为两大类:耐用性指标和完整性/可用性指标。

1.1. 耐用性指标 - 主要关乎寿命

1)TBW(Total Bytes Written)总写入字节数

- 定义:TBW指在保修期内,SSD可承受的总数据写入量。例如,一块3.84TB SSD的TBW可能为7PB。这是最重要的耐用性指标。

- 意义: TBW越高越好。对于持续写入密集的GPU工作负载(如数据预处理、模型训练检查点),需特别关注。

2)DWPD(Drive Writes Per Day)每日整盘写入次数

- 定义:DWPD指在保修期内,每天可写入SSD全盘容量的次数。DWPD = TBW / (保修年数 365天 硬盘容量)。

- 意义:DWPD更直观地反映SSD能否承受工作负载。例如,1 DWPD的盘适合普通应用,3-5 DWPD的企业盘适合高写入场景。

3)P/E Cycles(Program/Erase Cycles)闪存单元可编程/擦除的循环次数

- 定义:闪存单元可编程/擦除的循环次数,SLC > MLC > TLC > QLC。这是NAND闪存最核心、最底层的寿命度量单位,直接反映了闪存单元的物理耐用性。

- 意义:一个完整的“P/E Cycle”是指对一个闪存块进行一次擦除,然后将其写满。通常由厂商通过TBW/Warranty间接给出。

- 与SSD类型强相关:

| 颗粒类型 | P/E Cycles |

|---|---|

| SLC | ~100,000 |

| MLC | ~3,000 - 10,000 |

| TLC | ~1,000 - 3,000 |

| QLC | ~300 - 1,000 |

服务器SSD颗粒类型SLC、MLC、TLC、QLC与差异解析

1.2. 完整性、可用性与错误指标

1)UBER(Unrecoverable Bit Error Rate): 不可恢复误码率。指从SSD读取数据时,发生一个无法通过ECC等机制纠正的错误,所对应的已读取数据比特数。公式表示为:UBER = (不可恢复错误的数量) / (读取的总比特数)

- 标准: 企业级SSD通常要求≤10^-17(即每读取10^17比特,最多发生1个不可恢复错误),远高于消费级(10^-15)。

2)MTBF(Mean Time Between Failures): 平均无故障时间。在规定的条件下和规定的时间内,产品寿命单位(如小时)的总工作时间与故障总次数的比值。理论统计值,通常为数百万小时(如200万小时)。对单盘参考意义有限,更多用于衡量整体设计水平。

3)AFR(Annualized Failure Rate): 年故障率。表示在大量同型号设备构成的群体中,预计在一年内发生故障的设备数量占总体的百分比。AFR = (年内故障的设备数 / 同期内处于风险中的设备总数) × 100%,在保修期内的预期故障概率,通常为0.5%-0.9%。更直观。

4)数据保持期: 在断电、特定温度条件下,数据能可靠保存的时间。企业级通常要求3个月@40°C或更长。

5)RAS特性(Reliability, Availability, and Serviceability):

- 端到端数据路径保护: 确保从主机接口到闪存颗粒的数据传输全过程都有校验。

- 断电保护: 内置电容或电池,在意外断电时将缓存中的数据写入闪存,防止数据丢失。

- 智能错误恢复: 高级的纠错算法和坏块管理。

1.3. 性能一致性指标 - 对GPU工作负载至关重要

1)稳态性能: 在长时间、高压力、满盘状态下,SSD的IOPS、带宽和延迟的稳定程度。好的企业盘在稳态下性能下降幅度小。

2)QoS(服务质量): 通常用延迟的99.999%分位数(如99.999%的IO在1ms内完成)来衡量。这对于AI训练和实时数据库等敏感应用极其重要。

3)垃圾回收影响: 后台垃圾回收操作对前台性能的影响程度。

2. 测试方法与工具

测试需在实际服务器环境中进行,并模拟真实负载。

2.1. 基础信息与健康度检查

1)工具: smartctl (smartmontools), nvme-cli。

2)方法:

# 查看NVMe SSD的详细信息、SMART日志和关键寿命指标nvme listsmartctl -a /dev/nvme0n1nvme smart-log /dev/nvme0关键SMART项: Percentage Used(已用寿命百分比)、Available Spare(备用空间剩余)、Media and Data Integrity Errors、Critical Warning。

2.2. 性能与一致性测试

1)工具: FIO(最强大、最灵活)。官网地址为https://github.com/axboe/fio

2)测试场景:

- 预调理: 先用FIO写满全盘2-3次,使SSD进入“稳态”。

- 带宽/IOPS测试: 测试不同读写比例(100%读, 100%写, 70/30)、不同队列深度、不同块大小下的性能。

- 延迟测试: 重点测试低队列深度(如QD1, QD8)下的读写延迟。

- 长时间稳定性测试: 运行24-72小时的混合随机读写负载(例如4K QD32),并记录每秒的IOPS和延迟,观察其波动和下降情况。这是衡量性能一致性的核心测试。

3)示例FIO命令(稳态随机写):

# 基础单次运行测试(适合快速验证)fio --name=steady_state_randwrite \ --filename=/dev/nvme0n1 \ --ioengine=libaio \ --direct=1 \ --rw=randwrite \ --bs=4k \ --iodepth=32 \ --numjobs=4 \ --time_based \ --runtime=12h \ --group_reporting \ --eta-newline=102.3. 压力与异常测试

1)高负载耐久性测试: 使用FIO进行持续的大规模顺序写或随机写,记录TBW增长与SMART状态变化的速度。

2)满盘测试: 将盘填充至95%以上容量,测试其性能衰减情况。

3)异常断电测试:

- 在FIO进行高强度写入时,在受控环境(如测试实验室)下对服务器进行硬关机,然后重启检查文件系统完整性和数据一致性(需要文件系统支持校验,如ZFS)。

- 警告: 此测试有风险,需谨慎操作。

4)温度压力测试: 监控SSD在高温环境下的性能与错误率。smartctl可以读取温度。

2.4. 企业级功能验证

1)NVMe协议特性:

- 命名空间管理: 测试是否支持多命名空间以及隔离效果。

- SR-IOV/MU(Single Root I/O Virtualization / Multipath I/O, 单根I/O虚拟化 / 多路径IO): 验证虚拟化场景下的功能与性能隔离。

2)管理接口: 测试带外管理功能(如通过Redfish、IPMI)监控SSD状态。

白话GPU-08之GPU服务器Redfish干翻IPMI一文详解

3. 针对GPU服务器的特别建议

1)选择正确的产品层级: 务必选择企业级/数据中心级NVMe SSD,而非消费级。它们有更高的TBW/DWPD、更低的UBER和完整的RAS特性。

2)关注性能一致性: AI训练任务往往需要持续从存储读取数据集或写入检查点。稳态性能和QoS比峰值性能更重要。

3)监控与预警: 在生产环境中部署集中监控(如Prometheus + Grafana),持续采集SMART数据,对Percentage Used、Critical Warning等设置预警阈值。

4)考虑RAID与多路径: 对于关键任务,使用硬件RAID卡(支持掉电保护)或软件RAID(如mdadm)组建RAID 1/10,并结合多路径IO(如DM-Multipath)提高可用性。

5)文件系统选择: 使用对闪存友好、具有数据校验功能的文件系统,如XFS或ZFS(ZFS提供更强的端到端数据完整性保护)。

白话GPU-55 GPU服务器磁盘RAID使用场景分析

4. 测试流程总结

1)信息收集: 使用nvme-cli/smartctl记录初始SMART信息。

2)基准测试: 在空盘状态下进行简单性能测试(作为参考基线)。

3)预调理: 执行全盘顺序写入,使盘进入稳态。

4)稳态性能测试: 运行长时间的混合负载,记录性能曲线和延迟分布。

5)压力测试: 进行特定场景的压力测试(如满盘、高队列深度)。

6)验证与监控: 测试后再次检查SMART信息,验证无新增错误。在生产中持续监控。

最终,结合厂商规格书(关注TBW, DWPD, UBER)与实际负载下的性能一致性测试,是评估GPU服务器SSD可靠性的最有效方法。对于大规模部署,强烈建议在采购前进行POC(Proof of Concept,概念验证)测试。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。